Как составить продающий оффер (УТП) для сайта

Руководство по написанию торгового предложения, которое цепляет клиента в первые 10 секунд

Прочитав статью, вы научитесь важному бизнес-навыку — правильно формулировать и представлять ваше уникальное торговое предложение.

Даже если сделать сайт самому совсем сложно, возьмите один из одноэкранных шаблонов и поместите на него оффер — для старта будет достаточно.

А как составить уникальное торговое предложение мы рассмотрели в этой статье. Для этого мы выяснили, что включает в себя оффер, собрали экспертные мнения о его тестировании для российских сайтов и бизнесов и разобрались зачем оффер посетителю сайта.

А как составить уникальное торговое предложение мы рассмотрели в этой статье. Для этого мы выяснили, что включает в себя оффер, собрали экспертные мнения о его тестировании для российских сайтов и бизнесов и разобрались зачем оффер посетителю сайта.

Содержание

Часть 1: О чем хотят узнать посетители вашего сайта в первые 10 секунд

10 формул работы с заголовками сайта

Поведенческая психология в формировании лучшего оффера

Как указывать цену в зависимости от того, что вы предлагаете

Отличия в УТП B2B сегмента

Часть 2: Примеры и практика российского бизнеса

Резюме: 12 шагов к хорошему уникальному торговому предложению

Часть 1: О чем хотят узнать посетители вашего сайта в первые 10 секунд

10 формул работы с заголовками сайта

Поведенческая психология в формировании лучшего оффера

Как указывать цену в зависимости от того, что вы предлагаете

Отличия в УТП B2B сегмента

Часть 2: Примеры и практика российского бизнеса

Резюме: 12 шагов к хорошему уникальному торговому предложению

Часть 1: О чем хотят узнать посетители вашего сайта в первые 10 секунд?

Оффер (или уникальное торговое предложение) — это фраза, которая содержит суть вашего предложения (что вы предлагаете) и объяснение его выгоды для клиента.

Оффер отвечает на основные вопросы посетителя сайта здесь и сейчас. Он убеждает остаться на сайте, отправить вам заявку, купить ваш продукт. На это у вас есть несколько секунд.

Торговое предложение должно быть конкретным и понятным с первого взгляда. Ценность его для клиента должна быть очевидной. Как этого добиться?

Нил Пэтел (Neil Patel), консультант компаний Amazon, NBC, General Motors, The Hewlett-Packard, в своем блоге пишет о 8 вопросах, которые возникают в голове у клиента в первые 10 секунд. То, как вы на них ответите, повлияет на дальнейший сценарий: человек заинтересуется и останется, либо закроет вкладку и никогда про вас больше не вспомнит.

Мы взяли за основу вопросы Нила, адаптировали их под российскую реальность и вашу возможность сверстать лендинг пейдж самостоятельно на Тильде. Не забыли про поведенческую психологию, копирайтинг и дизайн. В итоге вы получите полное представление о том, как создать хороший оффер на Тильде.

Торговое предложение должно быть конкретным и понятным с первого взгляда. Ценность его для клиента должна быть очевидной. Как этого добиться?

Нил Пэтел (Neil Patel), консультант компаний Amazon, NBC, General Motors, The Hewlett-Packard, в своем блоге пишет о 8 вопросах, которые возникают в голове у клиента в первые 10 секунд. То, как вы на них ответите, повлияет на дальнейший сценарий: человек заинтересуется и останется, либо закроет вкладку и никогда про вас больше не вспомнит.

Мы взяли за основу вопросы Нила, адаптировали их под российскую реальность и вашу возможность сверстать лендинг пейдж самостоятельно на Тильде. Не забыли про поведенческую психологию, копирайтинг и дизайн. В итоге вы получите полное представление о том, как создать хороший оффер на Тильде.

1-й вопрос клиента: Что вы продаете?

Напишите, нарисуйте, спойте — дайте понять, о чем тут речь. Основные правила — ясность, ценность для клиента, точность.

“

Не заигрывайте с человеком. Дайте информацию — сразу емко и по делу.

Скажите словами: придумайте правильный заголовок

Оффер на сайте существует в форме заголовка и подзаголовка. Посетитель прочитает его первым, заголовок больше остальных элементов повлияет на судьбу продажи или лида.

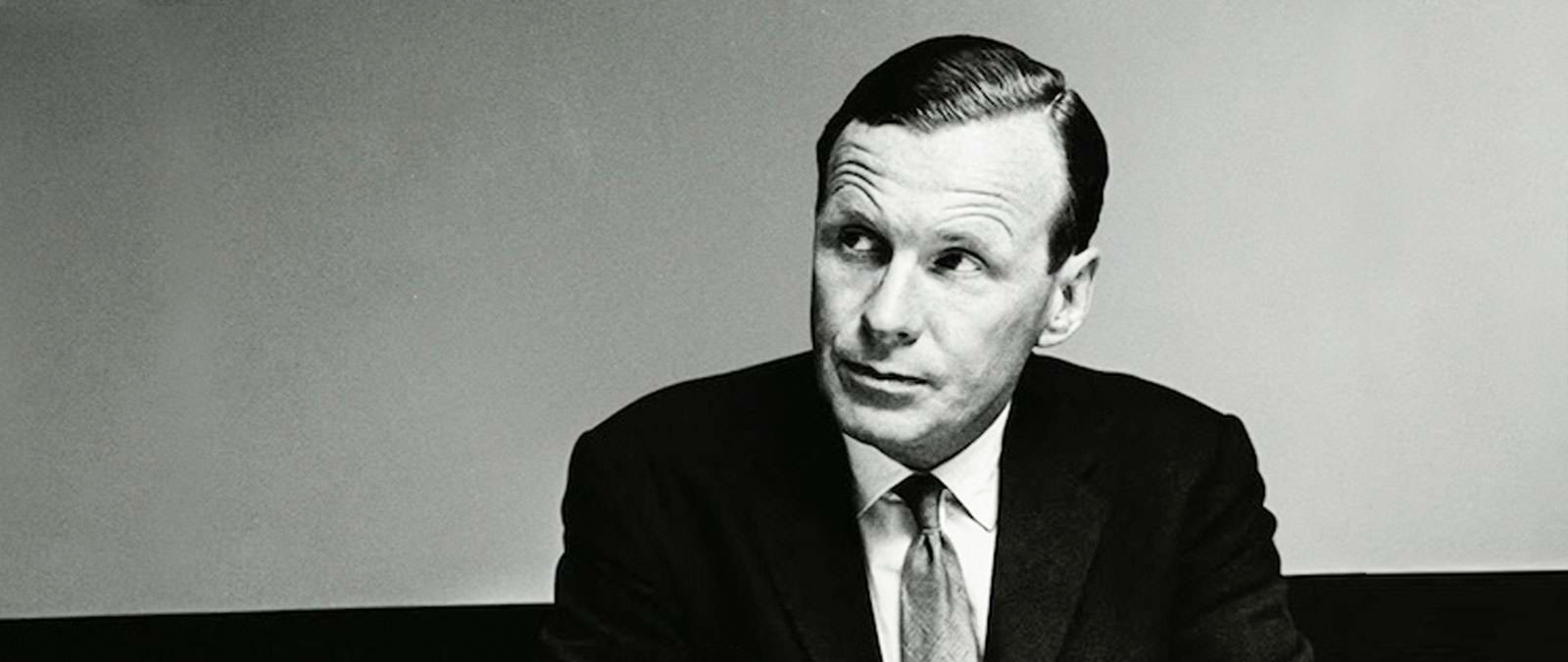

Самая распространенная методика хорошего заголовка — техника 4U — возникла до появления первого в мире сайта. Формулу идеального заголовка предложил Дэвид Огилви ещё в 50-е годы XX века. Но актуальность она не потеряла.

Самая распространенная методика хорошего заголовка — техника 4U — возникла до появления первого в мире сайта. Формулу идеального заголовка предложил Дэвид Огилви ещё в 50-е годы XX века. Но актуальность она не потеряла.

Дэвид Oгилви — основатель рекламных агентств «Ogilvy & Mather», «Ogilvy PR», успешный копирайтер. Многие признают Дэвида Огилви «отцом рекламы».

1

Полезность (Usefulness)

То, ради чего вы нужны клиенту. «Сэкономьте, улучшите, обезопасьте, накормите, порадуйте» — заголовок начинается с повелительного глагола.

То, ради чего вы нужны клиенту. «Сэкономьте, улучшите, обезопасьте, накормите, порадуйте» — заголовок начинается с повелительного глагола.

2

Уникальность (Unique)

То, чем вы отличаетесь от конкурентов. Предложение выгоднее по цене: «Коттедж в 2 раза дешевле квартиры». Оригинальность товара: «Новые системы безопасности».

То, чем вы отличаетесь от конкурентов. Предложение выгоднее по цене: «Коттедж в 2 раза дешевле квартиры». Оригинальность товара: «Новые системы безопасности».

3

Прицельность (Ultra-Specific)

Выгода клиента, измеримая в цифрах или процентах. «Сэкономьте до 4000 рублей», «Увеличьте конверсию оффера на 70%».

Выгода клиента, измеримая в цифрах или процентах. «Сэкономьте до 4000 рублей», «Увеличьте конверсию оффера на 70%».

4

Срочность (Urgency)

Ограничение предложения во времени. «Купите со скидкой до 15 апреля», «Используйте программу бесплатно 30 дней».

Ограничение предложения во времени. «Купите со скидкой до 15 апреля», «Используйте программу бесплатно 30 дней».

Если вы не смогли уместить все 4U в заголовок, сделайте это в подзаголовке или в маркированном списке. Но не забывайте — чем ниже на странице расположен текст, тем у него меньше шансов быть прочитанным.

Есть и современный вариант формулы: 4U+K. Он появился уже с популяризацией веб-страниц и лендингов.

«К» — ключевое слово, «вшитое» в заголовок для бесплатной SEO-оптимизации.Чтобы решить, какое словосочетание сконвертирует вашу аудиторию и даст хороший поисковый трафик, проверьте слова и сочетания вашего заголовка сайта:

Есть и современный вариант формулы: 4U+K. Он появился уже с популяризацией веб-страниц и лендингов.

«К» — ключевое слово, «вшитое» в заголовок для бесплатной SEO-оптимизации.Чтобы решить, какое словосочетание сконвертирует вашу аудиторию и даст хороший поисковый трафик, проверьте слова и сочетания вашего заголовка сайта:

Примеры элемента «К»

- С 10 марта и до конца весны. Бесплатная консультация визажиста в центре Москвы по европейской программе Fashion-TV".

- Продвижение сайта строительной компании. Увеличиваем поток клиентов на 40−300% за 3 месяца с гарантиями.

- Сэкономьте 5000 рублей. Музыкальная группа на свадьбу с 1 марта по 1 июня со скидкой.

10 формул работы с заголовками сайта

Попробуйте потренироваться в написании разных заголовков и выберите подходящий. Формулы и примеры помогут сориентироваться.

1

{ Качество продукта } [ SEO-фраза ], созданный для [ преимущество потребителя ]

Например: «Удобный конструктор писем, созданный для того, чтобы делать рассылки быстро и экономить время».

Например: «Удобный конструктор писем, созданный для того, чтобы делать рассылки быстро и экономить время».

2

{ Прилагательное } + [ Продукт / Услуга ] для [ характеристика целевой аудитории ]

Например: Дистанционный курс по HTML для девушек, мечтающих научиться программировать с нуля.

Например: Дистанционный курс по HTML для девушек, мечтающих научиться программировать с нуля.

3

[ Название продукта ] — это [ категория продукта ], который [ работа, которую он выполняет лучше других ]

Например: «Oki — это приложение для заказа еды, которое находит выгодные предложения в радиусе одного километра».

Например: «Oki — это приложение для заказа еды, которое находит выгодные предложения в радиусе одного километра».

4

[ Уменьшите боль / проблему ] [ неожиданным способом ]

Например: «Повышайте ваш доход, когда делаете покупки».

Например: «Повышайте ваш доход, когда делаете покупки».

5

[Делай что-то как [вдохновляющий пример] без [нежелательных последствий]

Например: Научись играть в теннис как звезда без изнуряющих тренировок.

Например: Научись играть в теннис как звезда без изнуряющих тренировок.

6

[ Занимайтесь желаемым делом ] без [ неприятных эмоций ] / [ неожиданным способом ]

Например: «Путешествуйте без ограничений, не бросая карьеру».

Например: «Путешествуйте без ограничений, не бросая карьеру».

7

{ Качество продукта } + { качество продукта } [SEO-фраза], который [ желанный результат ]

Например: Необычные авторские чехлы для телефона, которые защитят ваш телефон от ударов.

Например: Необычные авторские чехлы для телефона, которые защитят ваш телефон от ударов.

8

[ Действие ] + [ SEO-фраза ], за [ время ]

Например: Создавайте профессиональные презентации за 30 минут.

Например: Создавайте профессиональные презентации за 30 минут.

9

[ Обещание результата ] за [ время ]. [ Дополнительное преимущество ]

Например: Привезем, соберем и установим дом за один день. Обработаем поверхность противопожарным средством бесплатно.

Например: Привезем, соберем и установим дом за один день. Обработаем поверхность противопожарным средством бесплатно.

10

Делаем + { качество продукта } + [ продукт ], который [ преимущество потребителя ]

Например: Делаем доступные видеоролики для сайта, которые увеличивают продажи вашего бизнеса.

Например: Делаем доступные видеоролики для сайта, которые увеличивают продажи вашего бизнеса.

Не забудьте заключить заголовок в тег H1. Он находится на втором месте по важности в оптимизации SEO. На первом тег title, который подтягивается в качестве сниппета. Но если тег title отсутствует, то Google берет то, что заключено в H1.

В конструкторе Тильды это можно сделать так:

В заголовке важно не заигрывать с людьми. То есть, заголовок формата «Подари себе праздник» на сайте по продаже SPA-программ для женщин — провальный вариант. Люди должны зайти и без лишних усилий понять, что у вас продаются спа-программы и что эти спа-программы можно купить пакетом, по выгодной цене. Или вовсе сделать корпоративный заказ.

Многие грешат излишней креативностью и теряют за ней суть. При создании уникального торгового предложения не нужно такой самодеятельности: только четко и по делу.

Оффер — это текст. Но тексту нужна поддержка. Когда вы написали заголовок и подзаголовок страницы сайта, найдите нужную иллюстрацию. Виды могут быть разными. Все зависит от особенностей вашего товара: фото, рисунки, видео.

Покажите в картинках: добавьте иллюстрацию

Нельзя полностью полагаться на текст. Хорошая иллюстрация поможет заинтересовать человека. Картинки и видео человек воспринимает быстрее: не нужно включать логику, и воздействуют визуальные образы сильнее, так как сигнал идет напрямую к эмоциям.

Изображения превращаются в дополненную реальность, в которой участвует товар:

Продаете музыкальную группу? Снимите видео, где музыканты играют на мероприятии, вокруг танцуют и веселятся люди — ваша целевая аудитория.

Продаете дорогую сковородку? Поместить её в интерьер стильной и классной кухни, где ухоженная домохозяйка с хорошим маникюром жарит мраморные стейки.

Продвигаете услуги инструктора по сноуборду? Поместите фото или видео, как парень в ярком костюме лихо съезжает с горы, вокруг невозможно красивые виды и залитые солнцем сугробы. А потом он учит вас «за 2 часа — с нуля до первого склона».

Продаете музыкальную группу? Снимите видео, где музыканты играют на мероприятии, вокруг танцуют и веселятся люди — ваша целевая аудитория.

Продаете дорогую сковородку? Поместить её в интерьер стильной и классной кухни, где ухоженная домохозяйка с хорошим маникюром жарит мраморные стейки.

Продвигаете услуги инструктора по сноуборду? Поместите фото или видео, как парень в ярком костюме лихо съезжает с горы, вокруг невозможно красивые виды и залитые солнцем сугробы. А потом он учит вас «за 2 часа — с нуля до первого склона».

Иллюстрация закрывает несколько зон внимания:

- Создает настроение.

- Погружает в мир клиента и товара, где они рядом, бок о бок.

- Демонстрирует товар в действии — важный момент, который работает на доверие и снятие последних сомнений.

2-й вопрос клиента: Почему это может заинтересовать меня? Как это решит мои задачи?

Заголовок, подзаголовок и иллюстрация показывают полезность товара. Это первое и самое важное в иерархии 4U — Usefulness.

Разговаривать с клиентом на его языке и прочувствовать его боли — основной принцип всех удачных продаж. Делайте упор на то, чем вы полезны для посетителя сайта.

Усильте эффект — опишите ситуации, в которых клиент узнает себя и решает свои задачи с помощью товара. Добавьте в оффер сценарий.

Разговаривать с клиентом на его языке и прочувствовать его боли — основной принцип всех удачных продаж. Делайте упор на то, чем вы полезны для посетителя сайта.

Усильте эффект — опишите ситуации, в которых клиент узнает себя и решает свои задачи с помощью товара. Добавьте в оффер сценарий.

Если у вас намечается домашняя вечеринка, приготовьте стейки на своей кухне также хорошо, как шеф-повар в дорогом ресторане. Разные степени прожарки — внимание к гостям. Удивите всех с помощью нового электрогриля.

Или сверстайте выгоды клиента в маркированный список.

Поведенческая психология в формировании лучшего оффера

Продвинутые продажники давно применяют методы поведенческой психологии. Мы обсудили, какие формулы и сценарии можно использовать в оффере с Мариной Дорохиной, руководителем корпоративных продаж в Skyeng, Head of New Business Sales в Google, бизнес-тренером и коучером.

Марина Дорохина,

руководитель корпоративных продаж в Skyeng, Head of New Business Sales в Google, бизнес-тренер и коучер

Сформулировано множество формул поведенческих реакций, которые должен учитывать ваш оффер. Например:

AIDA — Attention, Interest, Desire, Action — Внимание, Интерес, Желание, Действие.

Это самая старая модель. Ее создал Элмир Левис в 1896 году в США. «Аиде» уже 117 лет (!), а она до сих пор хорошо работает и приносит владельцам бизнеса миллионы долларов. Сегодня появилось много интерпретаций этой формулы. Но главные компоненты системы остались неизменными. «Узнай, как заработать в Интернете $ 1000 в месяц, начиная с сегодняшнего дня!», «Продай свою квартиру за 1,5 месяца и на 10% дороже!», «Как научиться делать Landing Page за 1 час».

Из расширенных версий наиболее известна:

AIDAS — Attention, Interest, Desire, Action, Satisfaction — Внимание, Интерес, Желание, Действие, Удовлетворение.

Любое рекламное обращение должно привлечь внимание потенциального потребителя, затем вызвать его интерес, который переходит в желание обладать товаром (услугой) и, наконец, побудить к действию — покупке. Удовлетворение же означает, что после этих процедур нужно еще добиться того, чтобы потребитель остался удовлетворенным продукцией. Такой потребитель может рассказать о покупке родным и знакомым, стать постоянным клиентом компании и приобретать другие её продукты.

AIDA — Attention, Interest, Desire, Action — Внимание, Интерес, Желание, Действие.

Это самая старая модель. Ее создал Элмир Левис в 1896 году в США. «Аиде» уже 117 лет (!), а она до сих пор хорошо работает и приносит владельцам бизнеса миллионы долларов. Сегодня появилось много интерпретаций этой формулы. Но главные компоненты системы остались неизменными. «Узнай, как заработать в Интернете $ 1000 в месяц, начиная с сегодняшнего дня!», «Продай свою квартиру за 1,5 месяца и на 10% дороже!», «Как научиться делать Landing Page за 1 час».

Из расширенных версий наиболее известна:

AIDAS — Attention, Interest, Desire, Action, Satisfaction — Внимание, Интерес, Желание, Действие, Удовлетворение.

Любое рекламное обращение должно привлечь внимание потенциального потребителя, затем вызвать его интерес, который переходит в желание обладать товаром (услугой) и, наконец, побудить к действию — покупке. Удовлетворение же означает, что после этих процедур нужно еще добиться того, чтобы потребитель остался удовлетворенным продукцией. Такой потребитель может рассказать о покупке родным и знакомым, стать постоянным клиентом компании и приобретать другие её продукты.

Эти формулы — сценарии, которые вы можете взять за основу как пример уникального торгового предложения. Вести посетителя сайта по странице от пункта к пункту.

Но отметим, что такие заголовки и офферы не всегда работают. Рекламщики и владельцы бизнесов злоупотребляют такими формулировками — у пользователей естественным образом включается фильтр на такую схему подачи.

Но отметим, что такие заголовки и офферы не всегда работают. Рекламщики и владельцы бизнесов злоупотребляют такими формулировками — у пользователей естественным образом включается фильтр на такую схему подачи.

Иногда менее сенсационные заголовки работают лучше. Главное, чтобы они были из жизни клиента. Внимание захватывает актуальность.

Как увидеть свое преимущество и понять, что именно сделать крючком, на который цепляем посетителя? Все же надо использовать тестирование и разные зацепки для разных целевых групп.

Например, в книге «Заразительный» автор Йона Бергер приводит пример: «Кофе, выращенный в горах» — весь кофе растет в горах, но компания сделала это главным УТП (уникальным торговым предложением). Основой оффера.

Чтобы ответить на вопрос о преимуществах и правильно его выразить, нужно знать аудиторию и цепляющие её факторы.

Одна молодая мама заботится о здоровье ребенка и повернута на теме экологичности. В рекламе детского питания для неё важны — безопасность, отсутствие ГМО, происхождение продуктов. Для другой мамы решающим фактором будет цена. Для третьей — то, что это охотно едят все дети, и ребенок будет доволен.

Под каждую аудиторию надо писать свои тексты, и на каждой странице разделять эти месседжи. В идеале — сделать А/B тестирование, либо динамическую страницу с подменой на каждую целевую аудиторию.

Например, в книге «Заразительный» автор Йона Бергер приводит пример: «Кофе, выращенный в горах» — весь кофе растет в горах, но компания сделала это главным УТП (уникальным торговым предложением). Основой оффера.

Чтобы ответить на вопрос о преимуществах и правильно его выразить, нужно знать аудиторию и цепляющие её факторы.

Одна молодая мама заботится о здоровье ребенка и повернута на теме экологичности. В рекламе детского питания для неё важны — безопасность, отсутствие ГМО, происхождение продуктов. Для другой мамы решающим фактором будет цена. Для третьей — то, что это охотно едят все дети, и ребенок будет доволен.

Под каждую аудиторию надо писать свои тексты, и на каждой странице разделять эти месседжи. В идеале — сделать А/B тестирование, либо динамическую страницу с подменой на каждую целевую аудиторию.

Продолжим отвечать на вопросы, которые возникают в голове у пользователя. Каждый из них работает и самостоятельно, но может и входить в одну из этих формул.

3-й вопрос клиента: Чем вы отличаетесь от конкурентов?

Если вы нашли нишу рынка, где нет конкурентов, значит вы — Чан Ким или Рене Моборн — авторы книги «Стратегия голубого океана: как найти или создать рынок, свободный от других игроков». Чан Ким и Моборн предлагают подробные инструкции по выведению компании из состояния конкурентного стресса и созданию совершенно новой бизнес-модели.

В противном случае у вашего бизнеса от двух до десяти заметных игроков рядом. И посетители сайта должны понять — почему им надо купить у вас, а не у более опытных и надежных или молодых и ярких.

Развернутый ответ оставьте для раздела «О компании». В оффере разместите самое заметное конкурентное отличие.

В противном случае у вашего бизнеса от двух до десяти заметных игроков рядом. И посетители сайта должны понять — почему им надо купить у вас, а не у более опытных и надежных или молодых и ярких.

Развернутый ответ оставьте для раздела «О компании». В оффере разместите самое заметное конкурентное отличие.

Например

Вы продаете группу музыкантов, сопровождающую свадебные торжества. Все ансамбли играют каверы на почти одни и те же известные песни. Чем вы лучше?

- «Закажите одну группу на все мероприятие: от велком зоны до жарких танцев. Сэкономьте 70 000 рублей и свои нервы». Преимущество в том, что клиенту не надо будет заказывать несколько групп. Он может взять вас «оптом» по специальной цене. Для свадебного организатора плюс тоже очевидный — меньше подрядчиков, контактов, головной боли, затрат.

- «Вы удивитесь маленькой укулеле и электронной виолончели». Отличаетесь от конкурентов интересными инструментами. Не стоит забывать, что музыкальную группу не только слушают, на неё ещё и смотрят.

- «Споем на английском, французском, русском, португальском и цыганском. Без акцента». Тут упор на профессионализм, потому что свадьба высокого уровня и вокалист «спик фром май харт» — это несоединимые вещи. А если мероприятие международное, то хорошее знание языков и исполнение на них — основной козырь.

4-й вопрос клиента: Сколько стоят ваши услуги?

Не обязательно указывать цену в оффере на главной странице. Важно сделать быстрый и заметный путь к цене. В меню сайта, которое видно сразу и всегда, должен быть пункт «Сколько это стоит», «Цена», «Прайс-лист».

Чтобы понять, нужна вам цена на оффере или нет — протестируйте конверсии в обоих вариантах. Мы расскажем вам о реальном примере такого тестирования во второй части этого лонгрида.

Заявляете о цене сразу? Горячий вопрос многих продажников-новичков: какую цену указать — 28 или 27,99. Отвечают знатоки — Ник Коленда, предприниматель и автор блога о поведенческой психологии в маркетинге.

Исследования Ника опираются на академическую науку, это располагает к доверию.

Цены делятся на 4 типа:

Чтобы понять, нужна вам цена на оффере или нет — протестируйте конверсии в обоих вариантах. Мы расскажем вам о реальном примере такого тестирования во второй части этого лонгрида.

Заявляете о цене сразу? Горячий вопрос многих продажников-новичков: какую цену указать — 28 или 27,99. Отвечают знатоки — Ник Коленда, предприниматель и автор блога о поведенческой психологии в маркетинге.

Исследования Ника опираются на академическую науку, это располагает к доверию.

Цены делятся на 4 типа:

1

Округленные ($26)

2

Округленные с нулями ($45,00)

3

Точные ($36,47)

4

«Привлекающие» (19,99 или 46,95)

Второй тип не используйте никогда. Лишние нули будут «пачкать» оффер. Единственное место, где такие цены уместны — это таблица, где встречаются и целые числа. Столбец будет выглядеть опрятнее.

С первым, третьим и четвертым действует закон скорости восприятия. Круглая цена быстрее считывается, точная — дольше. Цены с окончанием в 99 или 95 — где-то посередине.

С первым, третьим и четвертым действует закон скорости восприятия. Круглая цена быстрее считывается, точная — дольше. Цены с окончанием в 99 или 95 — где-то посередине.

Если ваш товар относится к числу «эмоциональных», то сокращайте путь к решению о покупке. Укажите круглую цифру в стоимости. У посетителя будет меньше времени на поиски рациональных отговорок.

Закон действует и в обратном порядке. Если покупка «рациональная», то вам понадобится больше времени на обдумывание. В этом случае точная цена увеличивает время на когнитивные усилия мозга. Человек неосознанно сопоставляет потраченное время на обдумывание числа с общим временем размышлений над покупкой, и ему кажется, что он молодец — хорошо взвесил свой шаг.

Ник Коленда говорит, что если цена товара до $ 10 — используйте «привлекающую» цену. И для эмоциональной и для рациональной покупки. Мозг считает разницу между $ 6,99 и $ 7, как один доллар, потому что мы распознаем числа слева направо. $ 6,99 — это «шесть с копейками».

Ник Коленда говорит, что если цена товара до $ 10 — используйте «привлекающую» цену. И для эмоциональной и для рациональной покупки. Мозг считает разницу между $ 6,99 и $ 7, как один доллар, потому что мы распознаем числа слева направо. $ 6,99 — это «шесть с копейками».

Переведем на рубли

Например, эквивалентом $ 10 возьмем 100 рублей. 70 рублей и 69 рублей. Разница, на самом деле — в 1 рубль. Но внимание движется по числу слева право — это «60 с чем-то», а не «почти 70».

Вернемся к Коленде. Он пишет, $ 49 — это не «привлекающая» цена, а округленная. Но законы здесь действует те же. Разница между $ 49 и $ 51 — 2 доллара, но мозг считает её как разницу в десяток.

Потолок, после которого перестает действовать округленная цена на дорогие «эмоциональные» покупки — это $ 100.

Коленда удивляет простотой приема: чем больше шрифт, тем дороже кажется товар покупателям. В его исследовании все описано подробно.

Те же законы действуют и с длиной цены. Поэтому после $ 100 лучше использовать округленные числа — $ 1599, $ 129 или $ 999. А прием с окончанием на девятку будет работать в них также, как и в «привлекающих» ценах.

Это про «эмоциональные» покупки. В «рациональных» после $ 100 берите точные цены с числами после запятой. Вспомним цепочку: длинная цена = продолжительное время на ее осознание = я все делаю правильно, выбираю долго товар с приятной и тщательно рассчитанной ценой.

Потолок, после которого перестает действовать округленная цена на дорогие «эмоциональные» покупки — это $ 100.

Коленда удивляет простотой приема: чем больше шрифт, тем дороже кажется товар покупателям. В его исследовании все описано подробно.

Те же законы действуют и с длиной цены. Поэтому после $ 100 лучше использовать округленные числа — $ 1599, $ 129 или $ 999. А прием с окончанием на девятку будет работать в них также, как и в «привлекающих» ценах.

Это про «эмоциональные» покупки. В «рациональных» после $ 100 берите точные цены с числами после запятой. Вспомним цепочку: длинная цена = продолжительное время на ее осознание = я все делаю правильно, выбираю долго товар с приятной и тщательно рассчитанной ценой.

5-й вопрос клиента: Хочу больше знать о компании и товаре. Где почитать?

Ваше основное меню должно быть доступным. Желательно — видимым всегда.

На Тильде меню можно сделать фиксированным. В этом случае пользователь в любой момент может к нему обратиться.

Как это сделать: в настройках выбрать «Поведение: фиксирование при скролле».

На Тильде меню можно сделать фиксированным. В этом случае пользователь в любой момент может к нему обратиться.

Как это сделать: в настройках выбрать «Поведение: фиксирование при скролле».

6-й вопрос клиента: Кто ещё с вами работает?

Социальное одобрение имеет большой вес. Мы выбираем стоматолога по рекомендации друга. Ищем автосервис на форумах автолюбителей. Выбираем, кому отдать свою «ноготочки», через репосты подружек в соцсетях.

Традиционно на сайтах используют блок с логотипами компаний-заказчиков. Самый простой и быстрый способ.

Традиционно на сайтах используют блок с логотипами компаний-заказчиков. Самый простой и быстрый способ.

Но это не эффективный вид одобрения. Вы не показываете, что хорошего (или плохого) вы сделали для этих бизнесов. Чтобы оставить названия компаний-клиентов, но сделать этот текст полезным для пользователя, проработайте смыслы.

Например

Мы доставляем самую свежую семгу во все рестораны сети «Якитория» с 2015 года. Это около тонны рыбы, о которой мы знаем все.

Объедините портфолио с «именами» клиентов. Отлично работает подборка кейсов и реальных достижений.

Пример реализации на Тильде:

Пример реализации на Тильде:

Другой вариант — попросите клиентов оставить отзыв о вашей работе. Можно сохранить оригинальную пунктуацию, это придаст живости.

Если вы занимаетесь smm, и у вашей компании есть страницы в соцсетях, то самый «очеловеченный» способ подключить социальные доказательства — добавить на страницу сайта виджет группы vk.

Чтобы усилить действие вашей формы обратной связи, разместите доказательства возле СТА-кнопки.

Чтобы усилить действие вашей формы обратной связи, разместите доказательства возле СТА-кнопки.

Для влияния на очень осторожных пользователей перечисленных выше инструментов может быть мало.

7-й вопрос клиента: Можно ли вам довериться?

Добавьте в меню пункт, который будет вести на документацию и сертификаты качества. Такие меры нужны только в том случае, если вы продаете то, что в этом нуждается: продукты питания, медицинские или косметологические услуги, экстремальные виды развлечений, фитнес-услуги.

Но не выносите скрины этих документов на главную, пожалуйста.

Разместите полную контактную информацию, по которой компанию легко найти в реестрах. Укажите, как обменять или вернуть товар.

Но не выносите скрины этих документов на главную, пожалуйста.

Разместите полную контактную информацию, по которой компанию легко найти в реестрах. Укажите, как обменять или вернуть товар.

8-й вопрос клиента: Почему моей компании это может пригодиться?

Отличия в УТП B2B сегмента

B2B (англ. «Business to Business», рус «Бизнес для бизнеса») — продажи организациям, юридическим лицам.

B2C (англ. «Business to Consumer», рус. «Бизнес для потребителя») — продажи конечным пользователям для личного использования.

B2C (англ. «Business to Consumer», рус. «Бизнес для потребителя») — продажи конечным пользователям для личного использования.

Марина Дорохина,

руководитель корпоративных продаж в Skyeng, Head of New Business Sales в Google, бизнес-тренер и коучер

Ключевое отличие продаж B2B и B2C лежит в типе ЦА (целевой аудитории), к которой мы обращаемся. Но не все так очевидно. Решения о покупке в организациях принимают те же самые физические лица с их личной мотивацией. Примите во внимание тот факт, что за каждой покупкой стоит конкретный человек с его конкретными потребностями, нуждами, болями и проблемами.

Если проводить аналогию между продажами и спортом, то В2С — это спринт, а В2В — марафон".

Что влияет на решение о покупке: 9 отличий конечного пользователя и представителя бизнеса:

Если проводить аналогию между продажами и спортом, то В2С — это спринт, а В2В — марафон".

Что влияет на решение о покупке: 9 отличий конечного пользователя и представителя бизнеса:

Пользователь

1. Личные мотивы и вкусы — двигатель решения о покупке.

1. Личные мотивы и вкусы — двигатель решения о покупке.

Представитель бизнеса

1. Бизнесмен и сотрудник «не выключает» личные мотивы, но они перестают быть собственными. Они связываются с целями компании и задачами его должности.

1. Бизнесмен и сотрудник «не выключает» личные мотивы, но они перестают быть собственными. Они связываются с целями компании и задачами его должности.

2. На продажу влияет закрытие личных потребностей — решение может быть и рациональным, и эмоциональным.

2. Закрытие потребностей организации — главная цель. Здесь принятие решения дается труднее — риск выше. Сотрудник отвечает за бизнес-решение всей компании, а не свой личный вопрос.

3. На покупку работают импульсивность и эмоциональность.

3. Рациональные мотивы, логика, цифры и факты играют ключевую роль.

4. Относительно невысокая стоимость — плюс для покупки.

4. Покупка для бизнеса обычно стоит дороже — это пакет услуг или оптовая поставка. Сами цифры выглядят пугающе.

5. Пользователь сам принимает решение о покупке и делает это быстро.

5. Решение принимается группой — на это уйдет много времени.

6. Конечные покупатели — не эксперты в товаре или услуге.

6. В бизнес-покупках участвуют профессиональные закупщики и эксперты.

7. Пользователю важны рекомендации друзей и знакомых, социальное одобрение товара.

7. Бизнес, по аналогии с пользователем, ищет отзывы от других компаний. На первый план выйдет отраслевой опыт поставщика.

8. Из-за того, что покупка пользователя — это быстрое решение, нужен оперативный ответ от продавца. «Пока клиент горяченький».

8. Представитель компании будет взвешивать и выбирать между разными поставщиками. Для него важна оперативность, но обоснованность предложения куда важнее.

9. Если говорить о каналах воздействия, то для пользователя работают массовые коммуникации — через соц сети или прямую рекламу. И макро-дифференциации — социальные группы в сетях.

9. В бизнесе важен индивидуальный подход — прямые продажи и лоббирования, индивидуальные встречи и консультации. Сотруднику компании важны личные отзывы, т. е. микро-дифференциации.

Дайте вашей целевой аудитории именно то, что нужно ей.

И еще один секрет: не всегда то, что кажется работающим и самым классным с вашей точки зрения (или по мнению авторов сайта, лэндинга), будет работать для клиента. Любой вариант нужно тестировать. Именно на представителях вашей целевой аудитории".

И еще один секрет: не всегда то, что кажется работающим и самым классным с вашей точки зрения (или по мнению авторов сайта, лэндинга), будет работать для клиента. Любой вариант нужно тестировать. Именно на представителях вашей целевой аудитории".

Единых сценариев и идеального продающего оффера нет. Компания, которая хочет увеличить конверсию сайта и предложения, должна понять — кто её целевая аудитория и зачем её услуги нужны этим людям.

Компания, которая знает, чего хочет её клиент, может предложить ему разные варианты оффера. Сейчас мы говорим не о динамических страницах под разные seo-запросы, а о тестировании целевой страницы с точки зрения юзабилити.

Компания, которая знает, чего хочет её клиент, может предложить ему разные варианты оффера. Сейчас мы говорим не о динамических страницах под разные seo-запросы, а о тестировании целевой страницы с точки зрения юзабилити.

Часть 2: Примеры и практика российского бизнеса

Не бывает идеально составленного с первого раза оффера. Специалисты развиваются, руководители компаний узнают новое, бизнес эволюционирует.

Чтобы знать, что мы делаем хорошо, а где нужно подтянуться — тестируйте. Мы подразумеваем работу над каждым элементом и страницей в целом. Вы можете проработать только заголовок — найти самый работающий текст. Можете сверстать несколько вариантов оффера с разными дизайнами. И все это протестировать.

Мы публиковали схему для новичков — как провести свой первый A/B тест на Тильде. Сейчас мы сделали упор на практику и примеры российского бизнеса. Собрали мнения экспертов — руководителей российских бизнесов. Истории «с полей».

Мы публиковали схему для новичков — как провести свой первый A/B тест на Тильде. Сейчас мы сделали упор на практику и примеры российского бизнеса. Собрали мнения экспертов — руководителей российских бизнесов. Истории «с полей».

История первая: «Оффер протестировать невозможно, так как честное, нормальное А/В-тестирование вы не увидите»

Тестирование имеет сторонников и противников. Например, достаточно категоричное мнение высказал Денис Чудинов, руководитель студии дизайн и разработки мобильных приложений Lean Peaks.

Денис Чудинов,

руководитель студии дизайн и разработки мобильных приложений Lean Peaks

На мой взгляд, самый большой миф, который есть в IT-индустрии — это утверждение, что А/В-тестирование — универсальный метод улучшения показателей.

Я до своей компании занимался менеджментом проектов в штате других фирм, а еще до этого работал UX-специалистом, проектировал и занимался аналитикой. По опыту могу сказать, что почти ни у кого (по крайней мере в медиа) нет нормального А/В тестирования, поставленного на поток.

Я до своей компании занимался менеджментом проектов в штате других фирм, а еще до этого работал UX-специалистом, проектировал и занимался аналитикой. По опыту могу сказать, что почти ни у кого (по крайней мере в медиа) нет нормального А/В тестирования, поставленного на поток.

Личный опыт

На одном проекте (суточный трафик порядка 800 000 уникальных пользователей) мы как-то задались целью внедрить А/В тестирование. И столкнулись со сложностями. Разделю рассказ на три пункта.

На одном проекте (суточный трафик порядка 800 000 уникальных пользователей) мы как-то задались целью внедрить А/В тестирование. И столкнулись со сложностями. Разделю рассказ на три пункта.

Это очень трудно с точки зрения подготовки и измерения.

Даже если не брать А/В-тестирование, а разобрать «простой» пример, когда вы просто хотите добавить еще один рекламный баннер себе на сайт и измерить изменения в показателях.

Вы его добавили, и он стал приносить деньги. Что стало с другими баннерами и их конверсией? Вы стали больше получать денег? Через месяц вы можете выяснить, что другие баннеры просели и вы глобально уронили свой доход. А может это было связано с тем, что у вас изменились поставщики трафика и он стал другого качества? Нужно хорошо разобраться в возможных внешних причинах.

Тем более, что это означает что у вас должна быть очень круто настроена аналитика. Мы в своем проекте помимо Google Analytics и Яндекс. Метрики еще использовали серверную самописную аналитику и выгружали сырые данные в Excel для ручного подсчета. Как мне известно, крупные e-commerce проекты живут примерно так же (когда-то читал про аналитику lamoda). Они измеряют все в нескольких системах, так как они считают по-разному и дают разную погрешность. У одного и того же сайта данные посещений по ЯМ и GA могут сильно отличаться. По-настоящему сложные задачи эти системы решать не умеют.

А может так получиться, что с новым баннером вы за месяц заработаете чуть больше. Но в баннере ли дело? Может это сезонность сыграла или PR-компания в соц. сети? Пока вы тестируете, компания живет и развивается, очень трудно найти «чистый» месяц, который был бы без влияния маркетинга, портящего эксперимент.

А еще может получиться так, что кликать на баннер стали больше и ваш доход вырос, но ядро аудитории стало больше «раздражаться» и ее возвращаемость (или ретеншен) стал падать. То есть, через несколько месяцев вы потеряете аудиторию и, опять же, на круг заработаете меньше.

К чему я веду? К тому, что чисто статистически, учесть все причины и правильно измерить результат изменения очень трудно. Методологически (и математически) правильно считать естественную погрешность показателей, и если изменение дает рост больше погрешности — то это повод все перепроверить и убедиться, что у вас через квартал не упадут показатели.

Естественное колебание показателей может достигать 10%-20%, так что если вы поставили баннер и получили рост или падение прибыли на 5% — это ничего не значит.

А/В-тестирование — это очень затратно с точки зрения времени и денег.

А давайте одновременно показывать разные варианты разным людям, тогда мы не будем зависеть от изменчивости трафика, исключим сезонность и маркетинг?

Отличная идея. Казалось бы.

Если у проекта есть какая-то история и high-load, то есть настроено кэширование, разные сервера для контента и еще много всяких радостей, то вряд ли этот проект изначально затачивался на разветление продакшена. То есть архитектурно, проект не готов к тесту. Это значит что если вы придете к backend-программисту и скажете: «Коля, а давай мы 8% аудитории будем показывать вот эту верстку, причем они еще могут регистрироваться, нам нужно дать им отдельные куки, редиректы и все такое» — он озадачится.

Ваш первый А/В-тест будет полон технических сюрпризов и веселых моментов, особенно, если что-то отвалится, и вы перемешаете аудиторию. Конечно, в идеальных проектах такого нет, но в реальности встречается постоянно.

Когда вы с этим справитесь и даже потестируете что-нибудь, вы поймете что небольшие изменения дают небольшой результат. То есть если я на кнопке сделаю скругление краев и поменяю цвет с синего на зеленый — большинство пользователей или не заметят этого или вообще не обратят внимание, так как пришли в первый раз. Если вы хотите нормальный результат — делайте «крупные» изменения. Если у вас было 12 полей ввода для регистрации, а осталось 4 — то это существенное изменение. Только вот, если можете обойтись 4мя полями — это очевидно лучше и даст большую, для этого не нужен А/В-тест или дорогой UX-специалист.

Когда мне клиенты говорят что хотят А/В-тесты и это супер модно и круто, я им говорю что мы можем, только стоимость дизайна и верстки вырастет для них в полтора раза. А что? Вы же хотите 2 макета вместо одного. Выхлоп очень сомнительный по сравнению с затратами.

Другими словами, если вы просто сделали нормальный дизайн, продумали сценарий использования, посидели над текстами, нарисовали приятную графику — вы уже достигли «90% эффективности». Достичь оставшиеся 10% за счет интерфейсных улучшений очень и очень непросто.

Другие действия дают больше пользы.

Окончательным гвоздем в крышку А/В-тестирования является тот интересный факт, что вам проще поменять рекламодателя, провести конкурс в соц. сети, купить трафик в другом месте, оптимизировать кампанию в директе, запилить новую фичу в продукте или поправить баги — в общем заняться чем-то полезным, не трогая сайт. По себестоимости времени и денег вы окупите свои действия с большей эффективностью, чем занимаясь А/В тестами.

Почему тогда А/В-тесты так популярны?

Я думаю, потому, что крупные компании (Яндекс, Mail.Ru или Касперский) их используют и постоянно их пиарят. Для них они необходимы, так как эти компании уже попробовали все для своих продуктов и они «выжимают» камень в поисках крупиц пользы. У них есть на это ресурсы, деньги и желание.

Вот Яндекс. Музыка использует eye-tracking — целый набор инструментов, которые изучают куда смотрит глаз человека во время использования мобильного приложения. Да, штука полезная, когда у тебя есть бюджет. Не рекомендовать же это всем?

Отсюда вывод про кнопки и интерфейсы — делайте просто аккуратно, удобно и со вкусом. Этого будет достаточно. Если ваш продукт так себе, ни один интерфейс не исправит ситуацию.

Основа продажи — хороший продукт и здоровая коммуникация.

История вторая: «Любой оффер обязательно нужно тестировать. Это 100% доказано практикой»

Офферы обязательно нужно тестировать. Это 100% доказано практикой. Все дело в портрете вашей ЦА.

Здесь важно:

Здесь важно:

- проверять заголовки (как сработает один или другой посыл),

- картинки (сравните эффективность фото и графики),

- цвета,

- размер,

- расположение кнопок на странице и надписи на них,

- а также расположение и наличие отдельных элементов на странице.

Наши примеры из практики, которые это доказывают:

Первый и самый простой: мы запускали AB-тест CTA-кнопки с текстом «Попробовать бесплатно» и «Начать бесплатно» — одного цвета. Результат был ошеломляющим:

Первый и самый простой: мы запускали AB-тест CTA-кнопки с текстом «Попробовать бесплатно» и «Начать бесплатно» — одного цвета. Результат был ошеломляющим:

первый вариант текста обошел второй по числу конверсий в 5(!) раз. Длительность эксперимента с кнопками — 5 недель. Трафик за это время для этой страницы около 12 000 уникальных посетителей. Число конверсий соответственно — 16 и 89.

Еще один пример: мы проверяли страницу «Тарифы» на нашем сайте. В варианте страницы, на которой была кнопка «Начать чат с менеджером», открывающая виджет чата LiveTex, конверсия в беседу была в 6 раз выше — и большая часть разговоров с менеджером заканчивалась предварительной продажей. Эксперимент с тарифами — 2 месяца. Трафик — около 5 000. Число конверсий — 12 и 77.

И еще: наш лендинг под рекламу с отзывами клиентов оказался в 2 раза эффективнее абсолютно идентичного без отзывов.

Есть общие приемы повышения конверсии, которые вы можете найти на просторах интернета. Но они могут не сработать конкретно для вашей аудитории. Все нужно проверять на практике. Здесь нет универсальных «рецептов», у каждого сайта — свои особенности. Для одной группы пользователей может быть крайне важна цена, для другой — физические характеристики товара, для третьей -— наличие гибкой доставки. Попробуйте протестировать разные посылы, и вы увидите разницу: при правильном «сообщении» конверсии не заставят себя ждать.

Поэтому экспериментируйте, анализируйте и не переставайте совершенствовать свой сайт. И тогда высокие конверсии не заставят себя ждать!

Еще один пример: мы проверяли страницу «Тарифы» на нашем сайте. В варианте страницы, на которой была кнопка «Начать чат с менеджером», открывающая виджет чата LiveTex, конверсия в беседу была в 6 раз выше — и большая часть разговоров с менеджером заканчивалась предварительной продажей. Эксперимент с тарифами — 2 месяца. Трафик — около 5 000. Число конверсий — 12 и 77.

И еще: наш лендинг под рекламу с отзывами клиентов оказался в 2 раза эффективнее абсолютно идентичного без отзывов.

Есть общие приемы повышения конверсии, которые вы можете найти на просторах интернета. Но они могут не сработать конкретно для вашей аудитории. Все нужно проверять на практике. Здесь нет универсальных «рецептов», у каждого сайта — свои особенности. Для одной группы пользователей может быть крайне важна цена, для другой — физические характеристики товара, для третьей -— наличие гибкой доставки. Попробуйте протестировать разные посылы, и вы увидите разницу: при правильном «сообщении» конверсии не заставят себя ждать.

Поэтому экспериментируйте, анализируйте и не переставайте совершенствовать свой сайт. И тогда высокие конверсии не заставят себя ждать!

История третья: «Тестирование любых технологий в оффере — обязательное условие эффективной работы торгового предложения»

Марина Дорохина,

руководитель корпоративных продаж в Skyeng, Head of New Business Sales в Google, бизнес-тренер и коучер

Правила А/B тестов достаточно просты:

Как правило, тестируют следующие элементы веб-страниц:

Практика тестирования оффера в Skyeng.

Что касается меня, то в силу своей позиции я лично не занималась А/B тестированием, поскольку этим в компаниях занимаются специально выделенные и обученные люди. Но могу поделиться результатами тестирования лэндинга для корпоративных клиентов компании Skyeng.

Тестировали вопрос — насколько влияет на посетителей именно корпоративной страницы указание в лэндинге стоимости услуг. Первоначально была выдвинута гипотеза о том, что больше корпоративных заявок будут оставлять пользователи, просматривая лэндинг без указания стоимости. Поэтому были созданы 2 варианта лэндинга — один без указания стоимости услуг, другой с ценой. Как выяснилось по результатам тестирования, конверсия в лэндинге с указанием стоимости была на 37,04% выше, чем в лэндинге без неё. Именно поэтому в дальнейшем стали использовать только вариант с указанием стоимости.

- Все гипотезы нужно проверять — если что-то помогло кому-то другому, это не означает, что оно будет полезно и для вас.

- Тестировать одну идею (один элемент, одну гипотезу) в каждом тесте.

- Приступать к тестированию следующего элемента, только полностью закончив тестировать и вносить изменения в предыдущий.

- Фиксировать все результаты по каждому тесту отдельно.

- Четко определить сроки тестирования.

- Проверять однородность целевой аудитории.

- Данные поведенческого анализа пользователей и данные исследования аудитории могут не совпадать.

Как правило, тестируют следующие элементы веб-страниц:

- Текст и внешний вид конверсионных кнопок, а также их расположение.

- Заголовок и описание продукта.

- Размеры, внешний вид и расположение конверсионных форм.

- Макет и дизайн страницы.

- Цену товара и другие элементы бизнес-предложения.

- Изображения товаров и другие иллюстрации.

- Количество текста на странице.

Практика тестирования оффера в Skyeng.

Что касается меня, то в силу своей позиции я лично не занималась А/B тестированием, поскольку этим в компаниях занимаются специально выделенные и обученные люди. Но могу поделиться результатами тестирования лэндинга для корпоративных клиентов компании Skyeng.

Тестировали вопрос — насколько влияет на посетителей именно корпоративной страницы указание в лэндинге стоимости услуг. Первоначально была выдвинута гипотеза о том, что больше корпоративных заявок будут оставлять пользователи, просматривая лэндинг без указания стоимости. Поэтому были созданы 2 варианта лэндинга — один без указания стоимости услуг, другой с ценой. Как выяснилось по результатам тестирования, конверсия в лэндинге с указанием стоимости была на 37,04% выше, чем в лэндинге без неё. Именно поэтому в дальнейшем стали использовать только вариант с указанием стоимости.

История четвертая: «После всего опробованного, я — фанат Тильды». В картинках

Наталия Котляревская,

основатель и руководитель sofits.me

Как началась история наших экспериментов с оффером.

Нашу первую версию задизайнили дизайнеры и написали программисты. Поэтому на внесение любых, даже мельчайших изменений, требовалась куча времени, действий и координации. Тогда мы совершили большую ошибку маленького стартапа: мы думали о себе, как уже о большой компании. А надо было думать — как о маленькой лаборатории. Но это говорит мой сильный задний ум.

Первый оффер составлялся вдохновенно. Мы написали ТЗ, как мы его видели. Дизайнер это ТЗ воплотил. У нас сразу открывалась страница с подборкой образов, любой из них можно было посмотреть детально, купить вещи из него. А вверху был баннер с предложением пройти тест и посмотреть, какие из этих образов подойдут лично тебе.

Нашу первую версию задизайнили дизайнеры и написали программисты. Поэтому на внесение любых, даже мельчайших изменений, требовалась куча времени, действий и координации. Тогда мы совершили большую ошибку маленького стартапа: мы думали о себе, как уже о большой компании. А надо было думать — как о маленькой лаборатории. Но это говорит мой сильный задний ум.

Первый оффер составлялся вдохновенно. Мы написали ТЗ, как мы его видели. Дизайнер это ТЗ воплотил. У нас сразу открывалась страница с подборкой образов, любой из них можно было посмотреть детально, купить вещи из него. А вверху был баннер с предложением пройти тест и посмотреть, какие из этих образов подойдут лично тебе.

Вот так открывалась страница образа поверх главной:

Мы ничего не тестировали: ни заголовки, ни концепцию. Мы проверяли идею.

Потом стало ясно — что-то надо менять.

Идея не пошла. Пользователям не нравились вещи на моделях: они хотели видеть живых людей или не видеть их вообще. При переходе на сайт магазина часто оказывалось, что нужной вещи нет в наличии. Вообще, сама модель оказалась слишком сложной для восприятия — много шагов до покупки.

Уже тогда было (должно было быть) ясно, что не работает идея в целом. Но мы стали заниматься интерфейсом. Мы сделали красивую главную:

Идея не пошла. Пользователям не нравились вещи на моделях: они хотели видеть живых людей или не видеть их вообще. При переходе на сайт магазина часто оказывалось, что нужной вещи нет в наличии. Вообще, сама модель оказалась слишком сложной для восприятия — много шагов до покупки.

Уже тогда было (должно было быть) ясно, что не работает идея в целом. Но мы стали заниматься интерфейсом. Мы сделали красивую главную:

И еще:

В какой-то момент мы наконец-то слезли с дохлой лошади и обратились к пользователям. Мы предложили им личные услуги вместо общего для всех теста и подборки образов. Конечно, нам хотелось по всем канонам тестировать тучу версий интерфейса, но ресурса для этого не было, мы распылялись и теряли фокус.

Сейчас я думаю, что тестировать интерфейс нужно тогда, когда ты уже точно понял, что ты продаешь. И что это нужно пользователям.

Мы ушли от модели идея-дизайнер-верстальщик-программист и начали использовать конструкторы. У меня был опыт на Wix, но не очень удачный, поэтому мы попробовали LP Generator. Там было много вариантов, например (да, мне стыдно):

Сейчас я думаю, что тестировать интерфейс нужно тогда, когда ты уже точно понял, что ты продаешь. И что это нужно пользователям.

Мы ушли от модели идея-дизайнер-верстальщик-программист и начали использовать конструкторы. У меня был опыт на Wix, но не очень удачный, поэтому мы попробовали LP Generator. Там было много вариантов, например (да, мне стыдно):

Эти продукты с совершенно иной моделью монетизации уже пошли лучше.

И мы стали тестировать новые услуги и новые офферы:

И мы стали тестировать новые услуги и новые офферы:

В этом варианте мы пробовали разные заголовки, разные кнопки, смотрели конверсию. Но — опять же — все это тоже было не очень релевантно. Мы подсчитали, например, что для проверки одной гипотезы (а их были десятки), нам нужно не меньше 6 500 тысяч посетителей. На тот момент у нас не было такой возможности. Поэтому я думаю, что наши тесты не были корректными.

В декабре 2016-го, совсем недавно, сервис перекочевал на Тильду. Мне было ясно, что сайт нужно обновлять: мы определились со сценариями пользователей, сократили количество продуктов — это нужно было по-другому оформить. Плюс у нас почти половина пользователей заходят со смартфонов, а сайт смотрелся на них ужасно. На LP Generator мне пришлось бы переделывать все по 2 раза. А Tilda оптимизирует страницу под смартфоны сама. Это все и решило.

Плюс цена ниже, количество страниц больше, но главное — не нужно делать двойную работу.

Теперь уже, осваиваясь с сервисом, я вижу и удобство тестирования и смены интерфейсов, и мгновенный чат техподдержки, и, в целом, подход «Вы еще не знали, что вам это нужно, а у нас это уже есть, и удобно пользоваться».

Вот что у нас есть сейчас:

В декабре 2016-го, совсем недавно, сервис перекочевал на Тильду. Мне было ясно, что сайт нужно обновлять: мы определились со сценариями пользователей, сократили количество продуктов — это нужно было по-другому оформить. Плюс у нас почти половина пользователей заходят со смартфонов, а сайт смотрелся на них ужасно. На LP Generator мне пришлось бы переделывать все по 2 раза. А Tilda оптимизирует страницу под смартфоны сама. Это все и решило.

Плюс цена ниже, количество страниц больше, но главное — не нужно делать двойную работу.

Теперь уже, осваиваясь с сервисом, я вижу и удобство тестирования и смены интерфейсов, и мгновенный чат техподдержки, и, в целом, подход «Вы еще не знали, что вам это нужно, а у нас это уже есть, и удобно пользоваться».

Вот что у нас есть сейчас:

Как ни странно, удобство Тильды для составления оффера для сайта — в ограничениях: у Tilda много вариантов блоков под разные задачи. Но их конечное число, и они удобно структурированы. До сих пор я практически не сталкивалась с ограничениями: всегда находится выход с теми инструментами, которые есть.

Мы, конечно, используем готовые рекомендованные Тильдой блоки. Честно говоря, с Zero block я пока не разобралась. Несколько раз заходила — и уходила: не понимаю, как в нем работать. Да и функционала блоков хватает.

Сейчас оффер не окончательный — один из рабочих вариантов, которые мы сейчас проверяем. Сначала мы будем проверять модель, на что делать фокус. Потом — частности: слоган, текст, фотографии.

Мы, конечно, используем готовые рекомендованные Тильдой блоки. Честно говоря, с Zero block я пока не разобралась. Несколько раз заходила — и уходила: не понимаю, как в нем работать. Да и функционала блоков хватает.

Сейчас оффер не окончательный — один из рабочих вариантов, которые мы сейчас проверяем. Сначала мы будем проверять модель, на что делать фокус. Потом — частности: слоган, текст, фотографии.

Как мы тестировали.

На мой взгляд, несмотря на все наши потуги, это было интуитивное тестирование. Отличный термин для тыка пальцем в небо. По рассказу выше видно, как мы двигались — от медиа, зарабатывающего на комиссиях интернет-магазинов, к пользовательскому сервису.

На мой взгляд, несмотря на все наши потуги, это было интуитивное тестирование. Отличный термин для тыка пальцем в небо. По рассказу выше видно, как мы двигались — от медиа, зарабатывающего на комиссиях интернет-магазинов, к пользовательскому сервису.

Резюме: 12 шагов к хорошему офферу

Существует огромное множество теорий, сценариев, разработок и схем «идеального» торгового предложения. Изучите их все, найдите сходства и различия. Потом задумайтесь — зачем мой бизнес нужен людям? Вы будете готовы к созданию чего-то выдающегося.

Подведем итог нашей статьи в чек-листе:

1

Выделите свои конкурентные преимущества.

2

Выясните — кто ваша целевая аудитория.

3

Придумайте релевантный заголовок.

4

Добавьте хорошую иллюстрацию.

5

Говорите о пользе для клиента — постоянно.

6

Осознанно применяйте формулу AIDA — Внимание, Интерес, Желание, Действие.

7

Работайте над обозначением цены вашего товара.

8

Сделайте удобную навигацию.

9

Показывайте, кто с вами работает, и что они об этом думают.

10

Если вы продаете товар компаниям, скорректируйте оффер под бизнес-задачи.

11

Пробуйте улучшить каждую деталь вашего предложения.

12

Не бойтесь протестировать и понять, что вы провалили этап. Снова читайте, делайте, проверяйте.

Текст: Анна Антропова

Иллюстрации, дизайн и верстка: Юлия Засс

Иллюстрации, дизайн и верстка: Юлия Засс

Если материал вам понравился, расскажите о нем друзьям. Спасибо!

Читайте также: